Informace, entropie a fyzika

- Počítat neurčitost (entropii) v obecném případě

- Počítat přesné množství informace v obecném případě

- Že informace hluboce souvisí s fyzikou

Tato doplňková hodina uzavírá kapitolu o informaci. Aby byla studentům nějak ku prospěchu, měli by už dobře rozumět předchozí látce a také souvislostem z matematiky, tedy především pravděpodobnosti a logaritmu. Entropie není jednoduchý pojem, což ovšem platí i o konceptech z jiných předmětů. Někteří studenti tak mohou zůstat na úrovni „nejsem si jistý, co je entropie, ale vím, k čemu ji lze využít a jak“.

Vzorec pro výpočet entropie (resp. množství informace) je poměrně složitý přímé odvození je tak pro mnoho studentů příliš abstraktní. Jako efektivnější postup se jeví vzít vzorec „z nebe spadlý“ a na příkladech prozkoumat, jak se chová. Tedy že je v souladu s našimi předchozími výsledky, a někdy (tam, kde jsme dosud zaokrouhlovali a odhadovali) nám dává přesnější výsledky. Potom má smysl hloubat nad tím, proč se entropie počítá zrovna takovým vzorcem.

V závěru hodiny stojí za to načrtnout souvislosti s fyzikou. Ideální je domluvit se s vyučujícím fyziky a sladit se s jeho výkladem termodynamiky. Cílem není plné pochopení problematiky, bohatě stačí uvědomění, že souvislost existuje a má i nějaké důsledky. Zájemci pak v textu učebnice jistě objeví příležitosti k dalšímu zkoumání.

V každém případě se zde dostáváme na hranice toho, co lze považovat za středoškolskou látku. Není problém s touto kapitolou počkat (zejm. pokud studenti dosud nevládnou potřebnou matematikou a fyzikou), nebo ji úplně vynechat.

Obsah

Entropie v informatice

Na začátku jsme rozlišovali možnosti zcela jednoduše. Zvíře je, nebo není pták, číslo je, nebo není sudé. Takové zjednodušení nám pomohlo zjistit o pojmu informace většinu klíčových skutečností. Abychom ale byli fér a ušetřili si další školní deziluzi podle vzoru „i záporné číslo lze odmocnit“ a „i atomy jsou vlastně dělitelné, a navíc tam vůbec nikde nejsou žádné kuličky“, ukázali jsme, že je situace ve skutečnosti o něco složitější: obvykle nejsou všechny možnosti stejně možné. Víme nejen, co je možné a co není, ale také co je pravděpodobnější, než něco jiného. To potom ovlivňuje množství informace v souvisejících zprávách.

To, co jsme dosud označovali jako neznalost či neurčitost, tedy „to, co nevíme“, se nazývá entropie.

Entropie je dána rozložením pravděpodobnosti P jednotlivých možností s (z množiny všech možností S) podle vzorce:

Vzorec pro entropii může na první pohled vypadat poněkud strašidelně. Vystihuje ale to, co už vlastně víme. V případě rovnocenných možností jsme neurčitost odvozovali z počtu potřebných otázek k jejímu odstranění(neboli z výšky rozhodovacího stromu). Zcela přesný výsledek nám pak dal logaritmus. V obecném případě se musíme uchýlit k počítání váženého průměru počtu otázek, a zcela přesný výsledek nám dá entropie.

Tak jako obvykle, pokud jsou úvahy s pravděpodobnostmi příliš abstraktní, nahradíme je úvahami o konkrétních četnostech. Hodnota pravděpodobnosti odpovídá počtu odpovídajících možností n (z množiny všech počtů možností M) vydělenému počtem všech možností N (neboli součtem všech prvků M). Dostaneme tedy vzorec:

S pomocí známých vlastností logaritmu a sčítání samostatně ověř, že jej lze upravit na tvar:

Téhle podobě porozumíme snáz. Uvažujme o všech možnostech jednotlivě, s tím, že vícečetné možnosti se tedy vyskytnou vícekrát (viz obrázek níže). Potom první člen výrazulog(N) odpovídá počtu dotazů k určení konkrétní jednotlivé možnosti. Nás ale jednotlivé konkrétní možnosti nezajímají. Jakmile víme, do které skupiny možnost patří, jsme hotovi a můžeme se přestat ptát. Druhý člen výrazu(Σn n⋅log(n))/N nám říká, kolik otázek si tak ušetříme. Pro možnost s četností n si ušetříme log(n) otázek. Taková situace nastane n-krát. Počítáme průměr počtu ušetřených otázek vážený četností (jak často ušetříme kolik otázek).

Celý vzorec tedy počítá neurčitost tak, že možnosti „namnoží“ podle jejich četnosti, spočte výšku optimálního dotazovacího stromu pro všechny tyto možnosti. Od ní pak odečte průměrný počet otázek, který nebudeme muset položit, protože některé možnosti považujeme za totožné.

Příklad: Výpočet entropie

Entropie hodu (férovou) mincí

To je klasický příklad. Jsou dva možné výsledky, rub a líc. Oba dva jsou stejně pravděpodobné. Dosazením do vzorce dostaneme:

Neurčitost v situaci, kdy házíme mincí a nevíme, co padne, je tedy 1 bit. Informace o tom, co padlo, nám dá 1 bit informace.

To odpovídá našim očekáváním, ale nijak to neukazuje, že by počítání entropie bylo taky nějak zvlášť užitečné.

Informace je potom úbytek entropie, tedy to, na co jsme zvyklí: rozdíl mezi tím co víme před a po přijetí informace. S tím, že informace může obecně vzato možnosti nejen striktně vylučovat, může také zpřesňovat naše pravděpodobnostní odhady.

(Všimni si, že odčítáme jednou „po“ od „před“ a podruhé naopak. Proč?)

Příklad: Výpočet množství informace pomocí entropie

Na zahájení školní vánoční besídky 2013 přijede poslanec (nebo poslankyně). Kolik informace se o jeho stranické příslušnosti dozvíme z toho, že zastupuje Karlovarský kraj?

- Množství informace je rozdíl v entropii před a po zprávě, I = Hpřed - Hpo. Takže nejdřív spočteme ty entropie.

- Na začátku víme jen to, že jde poslance v období Vánoc 2013. VyhledámeOvěř u vhodného zdroje, jestli zde uvádíme správné údaje!, co nám to říká o jeho stranické příslušnosti. Četnosti jsou: 33, 50, 14, 14, 47, 26, 16. Všimni si, že je zcela jedno, o které strany se jedná. Celkový počet poslanců je 200.

- Pravděpodobnosti pro výpočet entropie odhademe pomocí nalezených četností a dosadíme do výše uvedeného vzorce.

-

- Pro entropii po přijetí zprávy musíme zjistit zastoupení stran za Karlovarský kraj. Ulehčeně zjistímeZjistili jsme to správně? Dovedeš to zjistit taky?, že je poslanců jen pět, a četnosti po stranách jsou 2, 2, 1. Všimni si, že jsme nejen některé možnosti zcela vyloučili, ale změnily se i četnosti možností zbylých.

-

- Zbývá spočítat rozdíl entropií:

- Upřesňující informace o daném poslanci nám poskytla 1,11 bitů informace o tom, ke které patří straně.

Ověř, jestli uvedené vztahy odpovídají tomu, co už známe, např.:

- našemu předchozímu zjednodušenému vzorci, kde byly pravděpodobnosti všech možností stejné(tedy rovny převrácené hodnotě počtu možností);

- situaci, kdy už víme vše - takže pravděpodobnost správné možnosti je 1 a všech ostatních možností nulaTo bude vyžadovat výpočet logaritmu nuly, ten ovšem obecně není definován. Pro účely výpočtu entropie je proto zvlášť stanoveno, že 0⋅log(0)=0.;

- (úplnému) vyloučení poloviny stejně pravděpodobných možností.

Najdi nebo vytvoř konkrétní příklad dané situace a propočítej neurčitost či informaci vhodným předchozím způsobem a pomocí nových vztahů. Porovnej výsledky. Potom zkus totéž udělat obecně, tedy bez konkrétních čísel. Výsledky opět porovnej.

Řešení

Ano, výsledky si odpovídají. Zvlášť důležitá je první situace, tedy N stejně pravděpodobných možnosti:

Entropie v případě stejně pravděpodobných možností je rovna logaritmu jejich počtu N:

Entropie ve fyzice

Pojem entropie původně pochází z termiky. Popisuje rozložení energie v daném systému. Je-li energie rozložena rovnoměrně, je termodynamická entropie vysoká. Jsou-li naopak v systému místa s různě velkým množstvím energie, např. místa s různou teplotou či tlakem, je termodynamická entropie nízká. Termodynamická entropie tak vyjadřuje, kolik práce může systém vykonat. To není totéž jako energie samotná. Když je energie rozptýlena rovnoměrně, není způsob, jak ji v rámci systému zužitkovat, nehledě na to, kolik jí je.

Často se lze setkat s připodobněním nízké entropie k řádu a vysoké entropie k chaosu. To je poměrně nešťastné, takto použité pojmy řád a chaos neodpovídají jejich chápání v běžné řeči - rovnoměrně rozptýlený plyn v nádobě se z našeho makroskopického hlediska jako chaos rozhodně nejeví, je to uspořádání zcela jednoduché a pravidelné. Nepořádek si mnozí představí jako nahodilé poházení věcí po pokoji. Taková představa ovšem intuitivně neodpovídá systému s vysokou entropií, tedy rovnovážnému stavu, kde jsou všechny teploty a tlaky vyrovnané.

Uspořádání makroskopických těles má od termodynamických zákonů velmi daleko. Není tam žádná tendence k rozpadu uspořádání. Termodynamickou a ostatní entropie nelze ztotožňovat zcela libovolně. Termodynamická entropie se vyznačuje mimo jiné tím, že má jasně danou úroveň mikrostavů a makrostavů.

Když už, tak je metafora nepořádku je užitečná spíše z druhé strany. Ukazuje, jak lze nepořádek a náhodu definovat: čím větší pořádek, tím stručněji umím stav popsat a naopak. Řád lze definovat jako cosi nepravděpodobného, oproti chaosu, který je pravděpodobnější. Pak z toho ale nelze pravděpodobnosti odvozovat.

Příklad: Plyny a nádoby

Klasickým úvodním příkladem na termodynamickou entropii je plyn v rozdělené nádobě. Máme-li v jedné polovině plyn natlakovaný a ve druhé žádný, je rozložení energieV dané situaci je to pohybová energie jednotlivých částic plynu. v systému nerovnoměrné, entropie nízká a schopnost konat práci vysoká. Na přepážku v nádobě přiděláme třeba větrník s generátorem a získanou energií si posvítíme na čtení nebo ohřejeme párek. Potom budou obě poloviny nádoby obsahovat plyn se stejnými vlastnostmi a ze systému už nedostaneme nic. Energie se rovnoměrně rozptýlila do celého objemu nádoby a entropie se zvýšila.

Obecně vzato nemusíme o entropii uvažovat jen v přímé spojitosti s pohybovou energií částic, můžeme pomocí ní vysvětlit i jevy zahrnující energii potenciální, energii chemických vazeb aj. - princip zůstává stejný.

Ale proč tu rozvádíme termodynamickou entropii? Podívej se na vzoreček, jakým se počítá:

, při stejných pravděpodobnostech Pi pak jednoduše

.

Povědomé, že? Právě tato podobnost výzkumníkům naznačila, že spolu neurčitost (tehdy ještě nepojmenovaná) z teorie informace a termodynamická entropie (tehdy jednoduše entropie) úzce souvisí.

Koncept makrostavů, mikrostavů a jejich přechodů je pěknou (a značně pokročilou) ukázkou stavového prostoru, což se může hodit v budoucí výuce.

V čem souvislost spočívá? Ve fyzice se při počítání termodynamické entropie pracuje s pojmy makrostav a mikrostav systému. Makrostav je dán tím, co přímo pozorujeme a jsme schopni rozlišit, např. teplota a tlak plynu ve dvou oddělených polovinách nádoby. Je nám přitom jedno, kde je která konkrétní částice. Mikrostav je to, co už nerozlišímeAť už proto, že to neumíme, nebo proto, že to nepotřebujeme, jelikož i práce s „hrubými“ makrostavy přináší dostatečně přesné výsledky., např. konkrétní poloha a rychlost Rychlost je vektor! všech částic v nádobě.

Stanovení úrovně makrostavu a mikrostavu je obecně vzato na nás jako na pozorovatelích. Není to žádná vlastnost systému jako takového, takže můžeme pro jeden systém rozlišit různé druhy entropií nabývající různých hodnot. Někdy budeme v mikrostavu rozlišovat přesné polohy částic plynu, v příkladu výše se třeba spokojíme s informací o tom, ve které polovině nádoby se která částice nachází. Termodynamická entropie odpovídá jedné konkrétní úrovni abstrakce vybrané šikovně tak, aby bylo možné změny entropie přímo vztáhnout k energii v systému.

Příklad: Stavy plynu v nádobě

Uvažujme naši rozpůlenou nádobu s deseti částicemi plynu. V makrostavech se budeme ptát jen na množství plynu v částech nádoby. Mikrostav je pak konkrétní rozdělení správného počtu částic plynu mezi poloviny nádoby.

| Makrostav | Mikrostavy |

|---|---|

| Vlevo je prázdno | Každá z deseti částice musí být v pravé polovině nádoby, to je tedy jediný možný mikrostav. |

| Vlevo je jediná částice | V levé polovině musí být vždy právě jedna z deseti uvažovaných částic. Je tedy 10 možných mikrostavů, které danému makrostavu odpovídají. |

| Vlevo je právě polovina částic | To už bude mnohem víc mikrostavů. Kolika způsoby lze vybrat polovinu z deseti částic? Pro představu si můžeme částice očíslovat a vybrané skupiny vypsat, tedy aspoň některé: 12345, 12346, ..., 12489, ..., 357810, ..., 578910, 678910.

Ptáme se vlastně přímo na počet pětiprvkových kombinací z deseti prvků, kombinatorika nám dá vzorec a výsledek: |

Hodnota entropie pak vychází z toho, kolik různých mikrostavů odpovídá danému pozorovanému makrostavu. Měří, kolika způsoby lze („makroskopicky“) nepozorovaně změnit vnitřní („mikroskopické“) uspořádání systému. Čím méně možných mikrostavů, tím menší entropie, a čím více mikrostavů, tím je entropie větší.

Z pohledu informatika: Čím méně možných mikrostavů odpovídá pozorovanému makrostavu, tím více o mikrostavu, tedy skutečné situaci „uvnitř systému“, víme. Nejraději jsme, když makrostavu odpovídá mikrostav jediný, takže je jasné který, o systému víme všechno a entropie je nulová.

Totéž můžeme říct i trochu jiným způsobem. Makrostavu s nízkou entropií odpovídá jeden z malé skupinky mikrostavů. Lze jej díky tomu přesně popsat poměrně úsporně, popis totiž nemusí nést mnoho informace. Naopak v případě makrostavu s vysokou entropií vyžaduje určení konkrétního odpovídajícího mikrostavu mnohem více informace (je třeba odlišit jeden z mnoha mikrostavů), a delší tedy musí být i samotný popis mikrostavu. Takto lze aspoň přibližně osvětlit vztah entropie z fyziky a z informatiky.

Druhý termodynamický zákon

V uzavřeném systémuUzavřený systém si nic nevyměňuje s okolím, tedy především hmotu, energii či informace. entropie samovolně neklesá. Druhý termodynamický zákon říká nejen to, že v horkém čaji se studenou lžičkou se teploty obvykle (rozuměj prakticky vždy) vyrovnají. Plyne z něj také pozoruhodná skutečnost, že čas plyne jen jedním směremTedy, možná ti to pozoruhodné nepřipadne, ale to je nejspíš dáno zvykem. Celý život se pohybujeme dle vlastní vůle prostorem, ale nikdy časem. Není ovšem jednoduché to nějak zdůvodnit..

Entropie dává nevratnosti dějů (a tím přeneseně i směru plynutí času) aspoň trochu uspokojivé vysvětlení. Systémy se vždy nachází v nějakém makrostavu a v nějakém odpovídajícím mikrostavu. Různým makrostavům přitom odpovídá různý počet mikrostavů. Některé makrostavy jsou tím pádem pravděpodobnější, než jiné. Navíc s realističtějším množstvím plynu a tedy počtem částic jsou rozdíly ještě výraznější, než jaké jsme viděli v předchozím příkladu s plynovou nádobou.

Naše úvaha o pravděpodobnostech je trochu zjednodušující. Není nijak zřejmé, že by všechny mikrostavy byly stejně pravděpodobné (proto je koneckonců ten vzorec počítá zvlášť). Vliv má například skutečnost, že systém nemůže z libovolného mikrostavu přejít do libovolného jiného mikrostavu. Je-li všechen plyn v jedné polovině nádoby, přeletí asi v příštím okamžiku do druhé poloviny několik částic, ale téměř jistě ne všechny. Rozlišujeme tedy vzájemnou dostupnost různých stavů. To ale efekt směřování k vyrovnaným stavům ještě víc posiluje.

Z každého mikrostavu jsou dostupné nějaké další mikrostavy, jenže těch blíže k vyrovnaným mikrostavům je víc. Aby se tak systém dostal daleko z rovnováhy (od stavu s vysokou entropií), musí přejít přes mnoho mezistavů, ovšem v každém z nich je největší pravděpodobnost toho, že se systém vrátí zpět k rovnováze. K původní úvaze (makrostavy s více mikrostavy jsou pravděpodobnější, bez ohledu na předchozí vývoj) jsme přidali právě ohled na to, jak se systém vyvíjí. Ukázalo to, že je směřování k rovnovážnému stavu a zvyšování entropie ještě silnější.

Je mnohonásobně pravděpodobnější, že se plyn v nádobě rozptýlí rovnoměrně, než že se nahromadí na jedné straně. Podobně je mnohonásobně pravděpodobnější, že po čase najdeme v čaji lžičku o teplotě čaje, než ochlazenou lžičku ve vroucím čaji. Je to proto, že rovnovážným makrostavům odpovídá zdaleka nejvíc mikrostavů, takže jsou tyto makrostavy pravděpodobnější. Po nějakém čase tedy uzavřené systémy v podstatě nevyhnutelně dosahují rovnovážných stavů s vysokou entropií. Chceme-li entropii v systému snížit, musíme vynaložit nějakou energii.

Z pohledu informatika: Entropie měří, kolik toho nevíme. Když je hodně zaměnitelných mikrostavů, tak toho a systému nevíme hodně. Druhý termodynamický zákon nám říká, že naše znalost o systému může samovolně leda klesat, nikdy nemůže bez vynaložení nějakého úsilí stoupnout.

Maxwellův démon

Navažme na náš příklad s plynem v nádobě. Abychom jej dostali z celé nádoby zpět do jedné poloviny, museli bychom ho stlačit třeba pístem, a dodat tak nějakou energii. Co takhle jít na to chytřeji? Doprostřed nádoby vrátíme přepážku vybavenou malými dvířky obsluhovanými hypotetickým Maxwellovým démonem. To je diblík, který dvířka otvírá, pokud k nim neletí žádná částice např. zleva, a naopak k nim letí částice zprava. Částice proto mohou přepážkou prostupovat pouze jedním směrem a plyn se postupně samovolně shromáždí v levé polovině nádoby. Potíž je v tom, že to znamená samovolný pokles entropie, a tedy spor s druhým termodynamickým zákonem. Z toho by mělo jasně plynout, že daný démon, např. ve formě automatu s čidlem a ramenem na ovládání dveří, nemůže existovat. Jenže na první pohled (a dalších skoro 60 let) není nijak zřejmé, proč by takové zařízení nemělo jít sestrojit.

Např. perpetuum mobile sice nejde sestrojit, protože odporuje termodynamickým zákonům, na každém jednotlivém stroji ale dovedeme určit, že ho zastaví např. ztráty třením. Diblíka nezastaví nic.

Nakonec se řešení(tedy vysvětlení, proč démon nemůže fungovat) našlo. Aby se totiž mohla dvířka správně otvírat a zavírat, musí nějaká čidla získávat informace o přilétajících částicích. A to vyžaduje energii. A aby démon mohl energii vydat, musí mu stoupnout (jeho vnitřní) entropie.

Jenže démon je samozřejmě součástí systému a my se musíme dívat na vývoj jeho celkové entropie — tady jak plynu, tak démona. Podrobnější rozbor by ukázal, že ztráty na ovládání dvířek přesáhnou zisk z toho, že se plyn nahromadí v jedné polovině nádoby. Vesmír tedy funguje tak jak má a my vidíme, že informace má přímý vliv na fyzikální děje.

Informace je fyzická

Vlastně by nás to nemělo překvapit. Už dříve jsme narazili na to, že informace musí být nějak zaznamenaná, tedy ve formě nějaké organizace hmoty. Termodynamika postupně ukázala, že taková organizace není jen tak něco bezvýznamného či virtuálního. Dlouho to nebylo zřejmé. Ta provázanost je totiž z hlediska každodenního života a našich běžných měřítek poměrně slabá. Množství částic a s ním i termodynamická entropie jsou oproti množství informace, se kterým obykle pracujeme, nepoměrně větší.

Přesto je informace s hmotou a energií těsně provázaná. Je-li informace nutně nějak hmotně reprezentovaná, její zpracování asi stojí nějakou energii. V principu je zásadní (kvůli druhému termodynamickému zákonu), jestli jsou děje nevratné, nebo vratné. Pokud jsou vratné, zákon nic moc neříká. Pokud jsou ale nevratné, musí entropie daného systému stoupnout, a u toho se musí uvolnit nějaká energie. Nevratným dějem je např. smazání bitu informace (kdyby to bylo vratné, nebylo by to smazání). Minimální související energie je v zeptojoulech10-21 Joule. Současná technika tento limit mnohonásobně překračuje, takže ještě máme co zlepšovat.

Mohli bychom si samozřejmě říct: tak proč mazat? Stačilo by nic nemazat, provádět výpočty tak, aby byly vratné, a potíže s energií by byly vyřešené. Takové řešení naneštěstí není moc praktické, protože jaksi nemáme nekonečnou paměť. Na to koneckonců existuje další principiální limit: v omezeném prostoru s omezenou energií může být jen omezené množství entropie. To je tedy zároveň maximální množství informace, které tam lze uložit. Podobně (s pomocí pokročilé fyziky) lze dojít k maximálnímu výpočetnímu výkonu jakéhokoliv počítače dané hmotnosti.

Mohlo by to vypadat, že takto jen fyzika limituje informatiku, a informatika fyzice nic nepřináší. Uvědomme si ale, že počítače jsou technická zařízení, která se řídí fyzikálními zákony. Takže když něco platí o jakémkoliv počítači, platí to o jakémkoliv fyzickém počítači. Tak například informatika fyzice ukáže, že obecně neumíme u každého fyzikálního systému říct, jestli se někdy ustálí.

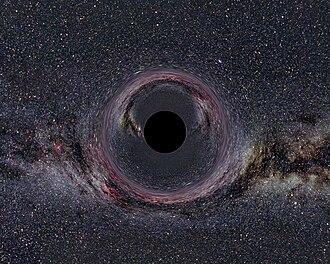

Jiným příkladem je problematika černých děr. Ve zkoumání jejich chování hrají informace a související fyzikální zákony ústřední roli. To se může jevit jako poměrně odtažité téma (jakkoliv je ve skutečnosti extrémně přitažlivé). Jenže právě v extrémních podmínkách se dobře odhaluje, jak a proč funguje vesmír v podmínkách obvyklejších. Klíčová otázka je, jestli se v černých dírách informace ztrácí (což by porušilo zákon zachování informaceZákonem zachování informace se zde myslí princip, kdy z úplné znalosti jednoho stavu systému (např. vesmíru), tedy ze znalosti všech vlastností jednotlivých elementárních částic v daném okamžiku lze jednoznačně odvodit stav předchozí nebo následující (bez ohledu na to, jestli my jako pozorovatelé někdy můžeme tu úplnou znalost získat, jako že nejspíš ne).

Takový princip jinde ve fyzice funguje, tak by bylo škoda, aby jej kazily právě černé díry.), nebo neztrácí (ale jak by to bylo zařízeno?).

Posledním střípkem, který zde zmíníme, je tzv. holografický princip. Vychází z poznatku, že informaci nutnou k úplnému popisu stavu části prostoru lze vždy vměstnat na povrch tohoto prostoru. Z toho se odvíjí úvahy o tom, že to podstatné se odehrává na „povrchu“ vesmíru a vnitřní objem není nijak důležitý. Na vesmír by šlo nahlížet tak, že informace je základem, a hmota a energie jsou „jenom“ doprovodné jevy.

Výše uvedeným souvislostem nemusíš do detailu porozumět (a ne, nebudou v písemce). Jsou jen ilustrací toho, jak fundamentální pojem informace ve fyzice je.

Shrnutí

Informace je úbytek entropie(neboli neurčitosti) způsobený přijetím zprávy:

Entropii počítáme z pravděpodobností jednotlivých možností s pomocí vzorce:

Měření informace pomocí entropie funguje správně i v případě nestejně pravděpodobných možností. Entropie vyjádřená v bitech odpovídá očekávanému počtu otázek nutných k jejímu odstranění (tedy k identifikaci jediné správné možnosti). To je totéž, jako průměrný počet bitů nutný k zakódování jedné takové možnosti při optimálním kódování.

S pojmem informační entropie úzce souvisí pojem termodynamické entropie. Z fyzikálních souvislostí plynou principiální vztahy a limity, např.:

- kolik energie přinejmenším stojí nevratná úprava jednoho bitu informace,

- kolik bitů informace lze vměstnat do dané hmotnosti o dané energii,

- jaký výpočetní výkon může mít počítač o dané hmotnosti.

Uvedené limity se opírají o fyziku mikrosvěta, kam jsme zatím se současnou technologickou úrovní nedospěli.

Pojem informace ale hraje důležitou roli např. v dosud nevyřešených kosmologických otázkách.